El 28 de febrero de 2015, un programador afroamericano llamadoJacky Alciné tuiteaba con evidente molestia: “Google Photos, ¡están jodidamente mal! Mi amiga no es un gorila”, después de que un sistema de Inteligencia Artificial (AI, por sus siglas en inglés) determinara que quien aparecía junto a él en una de sus selfiesno era una mujer de piel oscura, sino un gran simio de montaña.

Por ser gente negra la mal identificada en breve se hicieron acusaciones de racismo e incluso hubo quien aseveró que tales errores jamás se darían con caucásicos. Al día siguiente Yonatan Zunger, entonces ingeniero de Google y hoy jefe de la oficina de Ética de la empresa Humu, salió a aclarar: “¡Ojalá fuera así! Hasta hace poco nuestro algoritmo confundía a los individuos blancos con perros y focas. ¡El aprendizaje automatizado (machine learning) es difícil!”.

Sobre este punto el profesor Tom Froese, del Instituto de Investigaciones en Matemáticas Aplicadas y en Sistemas (IIMAS) de la UNAM, explica que, aunque nos fiamos demasiado de la AI, ésta tropieza y se va de bruces con más frecuencia de lo esperado pues, a diferencia de la inteligencia humana, ella opera con base en patrones y no entiende de lo subjetivo ni de significados.

“Tomemos un uno y un cero; para nosotros pueden representar los 10 años de nuestro sobrino, los miembros de una familia o las cuadras que faltan para llegar a casa, pero una computadora no sabe si estos números se refieren a una edad, a los pixeles de una postal o al dorsal que porta un futbolista en su camiseta. Para ella sólo son un uno y un cero a secas, y es incapaz de asignarles significado, algo que los humanos hacemos en todo momento y sin reparar en ello”.

En su artículo The Problem of Meaning in AI and Robotics: Still with Us after All These Years(recién publicado en la revista Philosophies, del MDPI y escrito en colaboración con Shigeru Taguchi, de la Universidad de Hokkaidō, en Japón), Froese disecciona una de las creencias más extendidas sobre la AI: la de que, por sus grandes avances en tan poco tiempo, en breve la inteligencia artificial será equiparable a la humana. “Mi postura aquí es de escepticismo, en especial tras verla fallar en aspectos donde nosotros no lo haríamos”.

Para entender por qué yerran hasta los algoritmos más sofisticados, el académico pone de ejemplo a GoogleNet, un sistema de AI que reconoce imágenes a través de redes neurales convolucionalesy que, de tan efectivo al hacer su tarea, ha habido quienes aseguran que en realidad entiende lo que está viendo. “¿Aunque puede hacerlo o simplemente nos gusta creer eso?”, pregunta Tom Froese.

“Dicho sistema es constantemente entrenado mediante aprendizaje profundo (deep neural learning), es decir, es puesto en contacto con millones de fotografías de donde obtiene patrones útiles para clasificar y, por lo mismo, se dice que ‘aprende’. Pero si introducimos una mínima alteración en la imagen que está por analizar podemos hacer que falle en grande y que ni siquiera se dé cuenta de ello”.

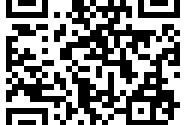

Sin comentarios